La direttiva europea sul copyright e gli effetti sulla SEO spiegati

Come forse saprai, da mesi infervora il dibattito attorno alla Direttiva Europea sul Copyright che promette di aggiornare e uniformare la normativa dei Paesi membri attorno al diritto d’autore. A luglio scorso la direttiva era stata votata e bocciata dall’aula, a settembre 2018 il testo è stato approvato dal Parlamento Europeo.

Questa normativa ha suscitato molto dibattito tra esperti di diritto, editori online, aziende dell’intrattenimento e fautori dell’una e dell’altra parte, e si propone di rendere uniformi e di modernizzare le nome rimaste ferme al lontano 2001 in fatto di tutela del diritto d’autore. Tutti sono d’accordo sul fatto che tali leggi vanno svecchiate, ma nessuno su come farlo, specialmente in relazione ad alcune regole espresse in forma vaga o troppo restrittiva.

Google è da tempo all’opera per valutare come dovrebbero cambiare le proprie serp (pagine dei risultati di ricerca) con l’eventuale entrata in vigore della normativa europea sul copyright, e a questo scopo ha svolto un esperimento per studiare gli effetti della direttiva sulle serp e sui risultati di Google News.

Questo esperimento, detto delle denuded serp, mostra che in caso di recepimento della direttiva le serp risulterebbero private di immagini di anteprima, parte di testo e di titoli di quei siti che non concedano l’autorizzazione al loro utilizzo, con conseguente calo stimato dei click.

In che cosa consiste la direttiva europea sul diritto d’autore e come influisce sulla SEO?

La direttiva europea è finalizzata ad armonizzare la legge sul copyright in tutta Europa e a venire incontro alle esigenze dei publisher online di ricevere un compenso economico diretto dall’utilizzo da parte di Google e dei motori di ricerca in genere di informazioni e immagini provenienti dai siti dei produttori di notizie.

Google infatti riporta quotidianamente foto, titoli e riassunti di notizie sulle proprie pagine dei risultati di ricerca e su servizi come Google News: gli stessi siti web sono predisposti per incorporare tag e dati strutturati atti a facilitare l’identificazione da parte dei crawler dei contenuti soggetti a scansione.

In particolare, dobbiamo tenere di conto le previsioni di due articoli della direttiva che sono altamente problematici:

• Articolo 11: prevederà che Google, Bing e altri aggregatori di news debbano riconoscere delle royalties quando utilizzano degli snippet di contenuti provenienti da siti di editori online

• Articolo 13: prevederà che piattaforme come Google, Youtube, Facebook e Twitter debbano monitorare in maniera attiva upload di potenziali lesioni del copyright o affrontarne le conseguenze

Da quanto leggiamo nell’articolo 11 i motori di ricerca dovrebbero essere autorizzati a produrre degli snippet dalle pubblicazioni di carattere giornalistico soltanto previo rilascio di una licenza dal detentore dei diritti.

Se ne parla a livello pubblico come di una vera e propria link tax volta ad assicurare ai produttori di contenuti un finanziamento in cambio di una concessione di licenza all’utilizzo.

Comunque, la tassa non è sui link veri e propri quanto sull’anteprima ipertestuale (immagine e testo di anteprima) che essi generano: per capirci non spetta a me che colloco un link nel blog pagarla, quanto ai servizi come Facebook o Google che creano delle anteprime visive cliccabili a partire da essi.

Nell’articolo 12 si legge che il detentore potrà “reclamare una quota del compenso previsto per gli utilizzi dell’opera”.

Stando all’articolo 13, i fornitori di servizi online dovrebbero accordarsi con i creatori di contenuti per ricevere una licenza, magari una sorta di “Content ID”, tale da impedire a monte la lesione del copyright degli aventi diritto. L’articolo 13 ha lasciato supporre che in pratica si potrebbe mettere a punto una sorta di filtro sui contenuti di per sé riduttivo della libertà di circolazione di informazione n rete.

Gli articoli 11 e 13 sono in pratica fulcro del problema, in quanto percepiti da molti come potenziali cause della limitazione della circolazione delle informazioni online.

I fautori della direttiva sostengono che questa legge permetterà agli editori di appoggiarsi a un sistema di creazione di contenuti più equo e sostenibile. L’idea alla base è che questi intermediari dai grandi poteri abbiano creato un business “sulle spalle” di produttori di contenuti di terze parti che si trovano in parte depauperati di almeno parte del valore dei propri prodotti editoriali.

Non è un mistero che tra i sostenitori della legge in discussione ci siano alcuni dei più grandi editori online e industrie dell’intrattenimento.

Coloro che la osteggiano sostengono che la legge sia espressa in termini vaghi e suscettibili di mal interpretazioni, e che possa rivelarsi un buco nell’acqua così come è stato nei casi precedenti di Spagna e Germania. Inoltre c’è la possibilità che possa tradursi in uno strumento atto a censurare in nome della protezione del copyright estesa a più non posso.

Tra gli oppositori abbiamo dei piccoli editori che, piuttosto che imbavagliare i motori di ricerca per quanto riguarda la capacità di presentare informazioni, opterebbero volentieri per cambiare i termini della normativa per sottoporre volontariamente i propri contenuti in barba a ogni restrizione.

Quali effetti dovrebbe avere la normativa sul copyright sulle serp di Google?

Se la Legge entrasse in vigore così come è attualmente, Google non potrebbe mostrare extract provenienti dalle testate online senza (eventualmente) pagare una commissione.

Ci ritroveremmo con serp prive di descrizioni o immagini, dai titoli dei siti scorporati da ogni elemento di contesto e incompleti.

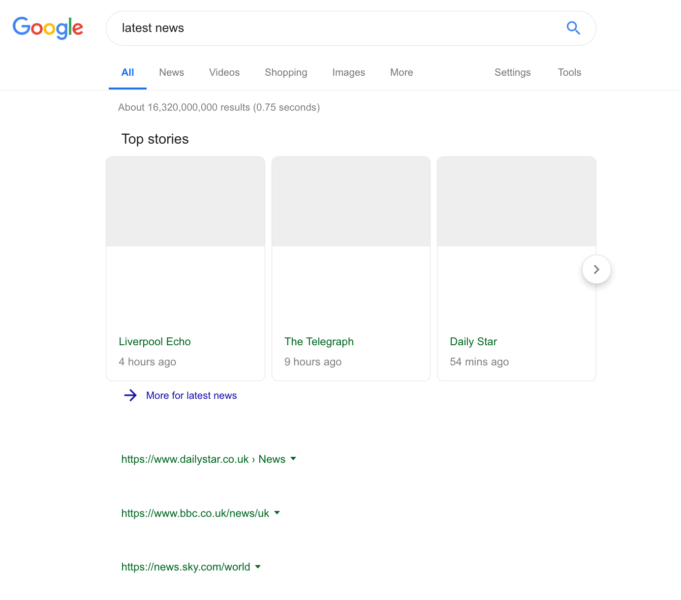

Google ha condotto un esperimento che ha condotto a un’anteprima di “serp denudate” per comprendere l’impatto della Direttiva Europea sul Copyright sugli utenti e sugli editori.

Come riporta Searchengineland nelle foto a seguire, l’applicazione della Legge allo stato attuale condurrebbe a mostrare:

• link senza testo o immagini

• titoli di storie incomplete

• titoli di testo privi di contesto

Di certo si tratterebbe di uno scenario ben poco avvincente dal punto di vista della spinta a cliccare per entrare nei siti. Google stessa stima che ciò condurrebbe a un calo del 45% del traffico verso i siti di news.

Di certo si tratterebbe di uno scenario ben poco avvincente dal punto di vista della spinta a cliccare per entrare nei siti. Google stessa stima che ciò condurrebbe a un calo del 45% del traffico verso i siti di news.

Come cambieranno le serp con la direttiva europea sul copyright: le mie opinioni

Per giudicare i pro e i contro di questa direttiva, dovremmo metterci nei panni sia degli utenti che cercano informazioni su Google che degli editori online che letteralmente vivono di ritorni economici sulla quantità e qualità del traffico che i loro portali riescono a ottenere.

L’editoria attualmente soffre di una grave crisi e questa misura sembra rivolta anche a offrire una boccata di ossigeno i publisher che hanno bisogno in qualche modo di integrare le proprie entrate.

Un aggiornamento della tutela del diritto d’autore è indubbiamente necessario, come in qualche modo riequilibrare i profitti tra creatori e distributori dei contenuti è sicuramente un fine lodevole.

Viene difficile da credere che molte tecnologie promosse da Google e altri colossi in questi anni per migliorare l’usabilità non abbiano come effetto collaterale quello di fornire risposte immediate agli utenti senza necessità di entrare nei siti che offrono le informazioni, con conseguente calo di traffico (e di guadagni) per questi ultimi.

Pensiamo a Google AMP (un’anteprima ultra-veloce dei siti che di fatto fornisce le informazioni rilevanti senza necessità d entrare nei portali veri e propri), ai rich snippet che offrono risposte a domande precise in box in evidenza, ai servizi che permettono di rispondere a domande frequenti senza bisogno di uscire dalle serp.

Però, è anche vero che questi strumenti possono rivelarsi preziosi per catturare pubblico da portare proprio verso i siti che attualmente si lamentano della situazione.

Però, è anche vero che questi strumenti possono rivelarsi preziosi per catturare pubblico da portare proprio verso i siti che attualmente si lamentano della situazione.

Quante volte, invogliati dalle informazioni dei rich snippet (box in evidenza in cima alla prima pagina), dal knowledge graph (il riquadro a destra che riassume le informazioni legate a entità persone fisiche o aziende), dai titoli accattivanti sulle serp abbiamo finito in effetti per approfondire sui siti in questione?

Possiamo avere una risposta immediata sull’ora esatta, sul tempo che fa, sul risultato delle partite, ma se vogliamo approfondire un concetto minuziosamente dobbiamo consultare i siti che compaiono appunto nelle serp.

Personalmente, consiglio proprio di investire nella realizzazione di contenuti attorno a intenti di ricerca connessi a chiavi di ricerca di coda lunga, in modo che i visitatori siano spinti effettivamente a navigare i siti per approfondire i concetti, e che le anteprime sulle serp non siano in grado di rispondere appieno.

La mia opinione è che regolamentisti e motori di ricerca dovrebbero mediare tra le rispettive esigenze di assicurare una tutela del copyright rispettosa degli sforzi profusi dai publisher e dei loro obiettivi di monetarizzazione, e quella di fornire alle persone risultati convincenti per colmare le proprie necessità di informazioni.

Un atteggiamento intransigente da ambo le parti condurrebbe appunto ai risultati desolanti delle serp sopra esposti, privi di qualsivoglia stimolo a cliccare.

Secondo le parole di Google stessa a proposito dell’esperimento:

<<All versions of the experiment resulted in substantial traffic loss to news publishers. […] “where we showed the publication title, URL, and video thumbnails,” there was a 45 percent traffic reduction to news sites>>

Piuttosto che pagare, è molto più facile che i colossi del web scelgano di restituire soltanto quei contenuti che non chiedono un corrispettivo per fare indicizzare i propri siti, con conseguente limitazione della circolazione delle informazioni e paradossalmente incremento delle fake news (siccome i bufaroli hanno tutto l’interesse a rendere i propri articoli sempre visibili).

In Spagna abbiamo già visto la chiusura a fine 2014 del servizio Google News, che stando a Google stessa non gli portava alcun ritorno economico e che perciò ha preferito chiudere piuttosto che rischiare di subire sanzioni.

L’obiettivo ultimo, oltre a quello sacrosanto di tutelare la paternità intellettuale dei creatori di informazioni, dovrebbe essere creare contenuti di qualità in modo che siano facilmente reperibili per le persone e tali da assicurare il mantenimento di coloro che li realizzano.

Allo stato delle cose attuali, potremmo avere invece un effetto censorio non voluto dal principio, ma come conseguenza collaterale dei paletti fissati.

C’è anche il problema che, a seconda delle interpretazioni e dei paletti che gli Stati membri metteranno a punto nel declinare la direttiva, l’obbligo di filtrare i contenuti gli upload possa gravare su ogni genere di sito, siccome le distinzioni in base alle dimensioni sono opinabili e quello che vale per Facebook in teoria potrebbe valere anche per il webmaster che gestisce un forum per passione.

Come tutelare il copyright di autori e creativi senza danneggiare la sana circolazione delle informazioni in rete?

Una risposta facile al dilemma nio on ce l’ho, e non ce l’ha nessuno, ma credo ci sia ancora da lavorare su quanto è al momento sui tavoli per perseguire gli obiettivi di cui sopra e contribuire al benessere generale.